À retenir

Les assistants vocaux, l'IA générative et de plus en plus, les agents d'IA s'intègrent dans notre quotidien et dans les processus décisionnels des entreprises.

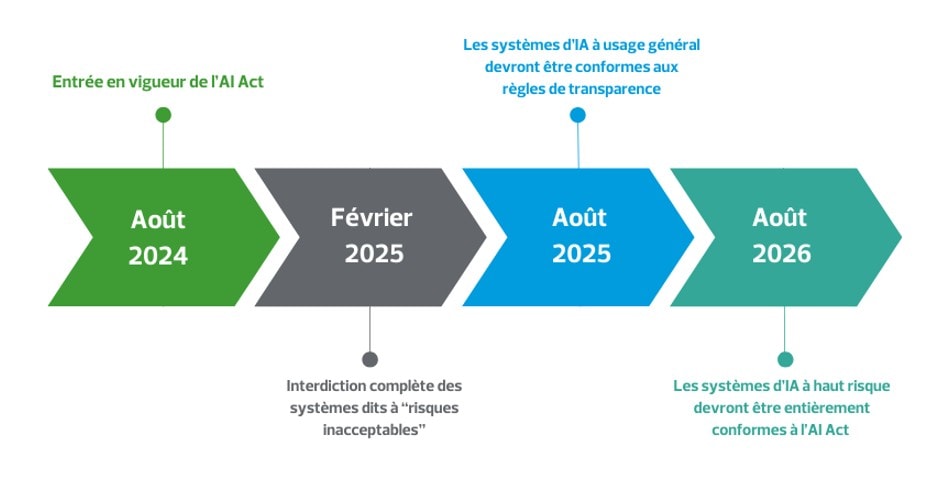

L'intelligence artificielle (IA) transforme nos sociétés de manière inédite. Face à l'ampleur des enjeux, l'Union européenne a adopté l'AI Act, le premier cadre juridique au monde spécifiquement destiné à l'IA, entré en vigueur le 1er août 2024. La pleine application de l'AI Act se fera progressivement sur plusieurs années pour permettre aux entreprises de s'adapter aux nouvelles exigences. Les principales échéances sont les suivantes:

Il vise à instaurer des règles claires et éthiques pour un développement ainsi qu'une utilisation de l'IA plus responsable au sein de l'Union européenne. En imposant des standards stricts, l'AI Act change radicalement la donne pour les entreprises, notamment en matière de transparence, de sécurité, de protection des droits des citoyens. Cette régulation n'est pas seulement un cadre à suivre: elle impose une nouvelle vision aux entreprises qui sont appelées à adapter leurs modèles et leurs processus pour intégrer une IA éthique et transparente.

Les entreprises qui anticipent dès maintenant ces échéances en intégrant les standards de l'AI Act à leur stratégie et à leurs pratiques auront un avantage significatif sur le marché: une longueur d'avance en matière de réputation et de compétitivité, en se positionnant comme des leaders d'une IA responsable et éthique.

Nos experts RSM vous proposent un décryptage des stratégies d'adaptation indispensables pour les entreprises face à cette nouvelle directive.

AI Act : le défi de la mise en conformité des entreprises

Quelles implications pour les systèmes d'IA existants?

L'AI Act introduit des contraintes substantielles pour les entreprises, en particulier celles qui utilisent des systèmes d'IA dits à haut risque. Le règlement impose en effet des normes strictes de transparence, de sécurité et d'éthique qui impliquent de revoir en profondeur les pratiques et infrastructures existantes.

Les entreprises ayant développé leurs propres logiciels d'IA avant l'adoption de l'AI Act doivent ainsi les adapter pour se conformer aux nouvelles exigences.

La mise en conformité peut nécessiter de modifier les algorithmes existants, de retravailler la structure des données et de s'assurer que les décisions prises par l'IA respectent les droits fondamentaux et la vie privée des utilisateurs.

Par exemple: un système de recrutement automatique devra prouver qu'il n'introduit pas de biais discriminatoires.

De même, un outil d'aide à la décision dans le domaine de la santé devra démontrer sa robustesse et sa fiabilité pour minimiser les risques pour les patients.

Pour de nombreuses entreprises, cela nécessite une analyse minutieuse et un audit complet de leurs systèmes actuels ce qui peut nécessiter des investissements importants et peut représenter un défi important pour certaines typologies d'entreprises, notamment les start-up Tech qui disposent de ressources limitées.

Quelles obligations clés?

Pour garantir la conformité de leurs produits aux standards européens, les entreprises devront dorénavant obtenir un marquage CE. Ce marquage exige que l'entreprise fournisse une documentation technique détaillée, qui inclut une description du système IA, ses fonctionnalités et les mesures de sécurité intégrées.

En complément de ce marquage, les entreprises devront inscrire les systèmes d'IA développés et/ou utilisés dans une base de données européenne accessible aux régulateurs.

La transparence et la traçabilité sont également essentielles.

Par exemple: les entreprises doivent être en mesure de documenter chaque décision prise par l'IA et de la justifier, ce qui suppose des archives exhaustives.

Par ailleurs, elles doivent garantir un contrôle humain pour superviser le fonctionnement des systèmes d'IA, notamment lorsque ces derniers sont classifiés comme étant à haut risque (high risk) par la réglementation.

À noter: un système d'IA est considéré "high risk" s'il est présent dans certains dispositifs médicaux et éducationnels.

Cette exigence de traçabilité implique la mise en place de système de surveillance continue pour détecter et corriger d'éventuelles erreurs ou dérives de l'IA, ce qui peut nécessiter des ajustements technologiques importants.

Investissements humains et financiers

Se conformer aux normes de l'AI Act représente un investissement financier significatif, surtout pour les entreprises qui utilisent de l'IA de manière intensive. Sur le plan financier, elles devront prévoir des budgets à allouer pour obtenir les certifications nécessaires, adapter leurs systèmes d'information et mettre en place de nouveaux processus de gouvernance et de surveillance.

En termes de ressources humaines, la mise en conformité avec l'AI Act nécessite une formation continue des collaborateurs, pour sensibiliser aux implications de la réglementation et des risques liés à l'utilisation de l'IA.

Par exemple: des sessions de formation sur les biais algorithmiques, la sécurité des données et la gestion de la vie privée seront essentielles pour les équipes techniques et managériales.

Les entreprises devront également recruter, former et faire évoluer certaines fonctions en des experts de gouvernance de l'IA, notamment pour des postes de responsables de la conformité IA ou de gestionnaires de risques, qui auront pour mission de s'assurer que les systèmes respectent bien les exigences du règlement.

Cet investissement en compétences permet aux entreprises, non seulement de rester conformes, mais aussi d'anticiper les futures évolutions réglementaires et technologiques. En renforçant leur expertise en IA responsable, elles peuvent en effet non seulement éviter les sanctions liées à la non-conformité, mais aussi gagner en compétitivité sur un marché qui valorise de plus en plus les pratiques éthiques et transparentes.

Gestion de l'IA : Gouvernance et réorganisation au cœur des enjeux

Une dynamique mondiale

L'AI Act s'inscrit dans une dynamique mondiale visant à établir une gouvernance responsable des technologies numériques et de l'intelligence artificielle. À l'échelle internationale, des initiatives comme la Recommandation de l'Unesco sur l'éthique de l'IA, adoptée en novembre 2021 par 193 États membres, ou encore le Pacte numérique mondial (Global Digital Compact), adopté en septembre 2024, soulignent l'importance d'un cadre éthique et transparent pour ces technologies. Ces efforts convergent vers une reconnaissance universelle des risques et opportunités liés à l'intelligence artificielle.

En complément, de l'AI Act, l'Union européenne a lancé le AI Pact, un programme de coopération volontaire pour accompagner les entreprises dans la transition vers la conformité. Ce pacte, articulé autour de deux piliers, joue un rôle clé dans la préparation des acteurs aux exigences réglementaires:

- La collecte et l'échange d'informations: le réseau du pacte pour l'IA permet aux entreprises, organisations et régulateurs de partager leurs bonnes pratiques et de mieux comprendre les implications de la régulation;

- L'encouragement à l'engagement volontaire: le pacte facilite la mise en œuvre des mesures de l'AI Act avant même leur application obligatoire, en offrant aux entreprises des outils et des ressources pour planifier leur mise en conformité.

Grâce au AI Pact, les entreprises peuvent anticiper les exigences légales tout en bénéficiant d'un environnement collaboratif pour innover de manière responsable. Cette initiative est également perçue comme un signal fort envoyé par l'UE à ses partenaires internationaux, affirmant son leadership en matière de régulation de l'IA. En encourageant les engagements volontaires, le AI Pact complète le cadre obligatoire de l'AI Act et reflète une volonté d'associer flexibilité et rigueur dans la gouvernance de l'intelligence artificielle.

Ainsi, en renforçant les liens entre les différents acteurs, qu'ils soient publics ou privés, locaux ou internationaux, l'Union européenne positionne l'IA comme un moteur de croissance éthique et compétitive, tout en inspirant une dynamique mondiale pour l'innovation durable.

IA: Quelle gouvernance et quelle gouvernabilité ?

L'AI Act impose donc une gouvernance de l'IA basée sur la surveillance, l'évaluation continue et la transparence. Les entreprises doivent ainsi s'assurer que leurs systèmes d'IA sont « gouvernables », c'est-à-dire qu'ils :

- sont sous contrôle humain;

- peuvent être ajustés ou arrêtés en cas de comportement inapproprié

Cela nécessite d'intégrer des outils de supervision et de régulation qui garantissent que l'IA reste alignée avec les objectifs et les valeurs de l'entreprise. Certaines plateformes proposent des guidelines sur la gouvernance à mettre en place pour une intégration réussie d'un système d'IA.

Une gouvernance efficace repose sur une documentation exhaustive.

Par exemple: pour un système de recommandation de produits, l'entreprise doit être capable de justifier pourquoi un utilisateur a reçu une recommandation spécifique et démontrer que ce choix est exempt de biais discriminatoires. Cela implique d'établir des protocoles de vérification des algorithmes, une documentation technique détaillée et des audits réguliers pour maintenir un contrôle strict sur le fonctionnement de l'IA.

Ces obligations de transparence et de gouvernabilité imposent une rigueur qui n'était pas systématiquement présente dans les pratiques de nombreuses entreprises, en particulier celles qui n'avaient pas encore l'habitude de documenter et de contrôler leur IA avec autant de précision.

Quels impact dans les processus décisionnels et quel rôle pour les comités exécutifs?

L'AI Act ne se limite pas à des ajustements techniques: il impose une transformation en profondeur des processus décisionnels au sein des entreprises. Avec cette régulation, les entreprises doivent intégrer l'éthique, la transparence et la responsabilité dans leurs valeurs fondamentales, notamment pour rassurer les clients et les partenaires sur l'intégralité de leurs technologies d'IA.

La mise en œuvre de l'AI Act repose en grande partie sur l'engagement des comités exécutifs, qui jouent un rôle crucial dans l'élaboration et le suivi d'une stratégie IA cohérente et conforme. Cela pourrait impliquer la nomination de responsables de la conformité à l'IA - des spécialistes qui peuvent superviser les règles éthiques et les normes de sécurité de l'IA au sein de l'organisation. Ces responsables peuvent être des délégués à la protection des données (DPO) ou encore des Chief AI Officers, selon la taille de l'entreprise et la complexité de ses activités en IA.

Le comité exécutif a également la charge de créer un environnement de travail qui favorise la collaboration entre les différentes équipes, notamment entre les équipes techniques (développeurs, data scientists), les métiers et les équipes juridiques, d'audit, de contrôle interne et de conformité. Ces groupes doivent travailler de concert pour anticiper les risques et assurer une surveillance continue des systèmes d'IA. Ce mode de gouvernance renforce ainsi la transparence interne et permet une meilleure adaptation aux exigences réglementaires.

L'intégration de « digital factories »

La mise en place de « digital factories » – des unités ou divisions dédiées au développement à l'intégration de solutions numériques et d'IA - est également une des options pour faciliter la conformité. Ces entités internes permettent d'assurer un contrôle plus strict des applications IA, en s'assurant que chaque étape de la conception, du test et du déploiement respecte les normes de transparence et d'éthique fixées par l'AI Act.

Les « digital factories » centralisent les compétences et les ressources nécessaires pour développer et superviser l'IA dans l'entreprise, créant ainsi un cadre de gouvernance qui garantit la cohérence des pratiques de conformité aux standards. Ces unités peuvent aussi faire office de laboratoires d'innovation, permettant de tester des solutions d'IA de manière sécurisée tout en assurant la documentation et la traçabilité requises. En déployant de telles structures, les entreprises démontrent leur engagement envers une IA éthique et responsable, tout en se préparant aux futures évolutions réglementaires.

AI Act: anticipation et cartographie des risques

Cartographie des risques et mise à jour

L'une des exigences fondamentales de l'AI Act pour les entreprises est de réaliser une cartographie des risques liés à leurs systèmes d'IA. Cette cartographie est un exercice crucial pour identifier et analyser les risques spécifiques que chaque modèle d'IA peut poser, que ce soit en termes de sécurité, d'éthique ou de respect des droits fondamentaux.

La mise à jour régulière de cette cartographie est également indispensable pour garantir une conformité continue. Avec l'évolution constante des technologies et des réglementations, les risques associés à l'IA peuvent changer rapidement. Les entreprises doivent donc s'assurer que cette cartographie est dynamique et qu'elle s'adapte aux nouveaux défis - réglementaires ou technologiques - au fur et à mesure de leur apparition.

Cette approche permet une réactivité essentielle pour rester en conformité tout en minimisant les impacts négatifs de systèmes d'IA sur les utilisateurs et les parties prenantes.

Vision stratégique à long terme

L'AI Act pousse les entreprises à adopter une vision stratégique et technologique à long terme pour anticiper les risques et tirer le meilleur parti de l'IA tout en restant conformes. Pour assurer leur survie dans un environnement technologique en constante évolution, les entreprises doivent développer une stratégie IA qui prend en compte à la fois les opportunités et les risques futurs. Cela inclut une veille réglementaire et technologique régulière, qui permet de rester informé des évolutions dans le domaine de l'IA et des modifications éventuelles du cadre législatif.

Cette vision à long terme implique aussi des investissements dans des technologies qui facilitent l'adaptation rapidement aux nouvelles exigences de l'AI Act.

Par exemple: les entreprises peuvent adopter des outils d'analyse prédictive pour identifier les risques avant qu'ils n'affectent les utilisateurs pour les clients.

Une approche proactive et anticipative permet aux entreprises de se préparer efficacement aux évolutions futures, renforçant ainsi leur résilience et leur compétitivité sur le marché.

Gestion des compétences et formation continue

Il est exigé des entreprises qu'elles développent et forment des compétences spécifiques pour anticiper et gérer les risques liés à l'intelligence artificielle. Cette formation est essentielle pour sensibiliser les collaborateurs aux différents aspects de l'IA, tels que la détection des biais, la gestion de la sécurité des données et la protection des droits individuels.

Pour répondre aux exigences de l'AI Act, les entreprises doivent former leurs équipes aux bonnes pratiques en matière de gouvernance de l'IA, afin que chaque collaborateur impliqué dans l'IA ait une compréhension claire des obligations et des risques associés.

Des programmes de formation continue sont particulièrement recommandés pour les employés qui travaillent directement avec des systèmes d'IA comme les développeurs, les data scientists et les responsables de conformité. Ces formations permettent de maintenir un niveau de compétence adéquat face aux évolutions constantes des technologies et des réglementations. En plus de la formation interne, certaines entreprises choisissent d'organiser les ateliers de sensibilisation à l'IA pour les équipes transversales (par exemple pour les départements marketing ou service client) afin qu'elles comprennent comment l'intelligence artificielle influence leurs activités et comment réagir en cas de problème éthique ou de non-conformité.

L'AI Act incite les entreprises à adopter une IA en phase avec les valeurs européennes, axée sur la transparence et le respect des droits d'utilisateurs. Les entreprises ont un rôle à jouer dans la promotion d'une intelligence artificielle éthique et responsable dans la construction d'un espace numérique de confiance. Cette régulation représente ainsi un levier puissant pour renforcer à terme la compétitivité et la résilience des entreprises dans un environnement de plus en plus tourné vers la technologie. En prenant le virage de la conformité et en s'adaptant aux nouvelles exigences dès aujourd'hui, les entreprises européennes consolident leur place dans un marché international exigeant tout en affirmant leur engagement pour une innovation durable et éthique.